Высшая точка Лоихи (более точное написание, отражающее особенности аборигенной фонетики, — Lö’ihi, «длинная») поднимается над окрестным океанским дном на 3 с лишним км, а от поверхности её отделяет менее 1 км. Гора эта, даром что скрывается под водой, очертаниями своими — вплоть до наличия явно выраженной кальдеры — сильно напоминает уже находящиеся на поверхности активные вулканические вершины архипелага: Килауэа и Мауна Лоа. Если верна хорошо обоснованная геологами теория горячих точек (hot-spot theory), то через какое-то время Лоихи поднимется, став очередным полноценным островом — сперва, понятное дело, небольшим, потом всё крупнее и крупнее — в Гавайской гряде.

Аналогия с нейроморфными вычислителями тут вполне прозрачна: пока что те, как и соименный интеловскому чипу вулкан, пребывают в «подводном» состоянии; на стадии в лучшем случае предсерийных, а то и вовсе лабораторных прототипов, а в худшем — и просто не выходя за рамки чисто умозрительных концепций. Со временем, однако, ожидается их «выход на поверхность» — в виде полностью готовых к массовому производству и широкому применению изделий. А пока даже сам микропроцессор Loihi, доросший ещё в 2021 г. до второго поколения (и третье, хочется верить, теперь уже где-то на подходе), представляет собой некий компромисс между подлинно аппаратной и целиком программной нейроморфностью — компромисс, вполне заслуживающий тем не менее нашего пристального внимания.

⇡#Кремний-выручалочка

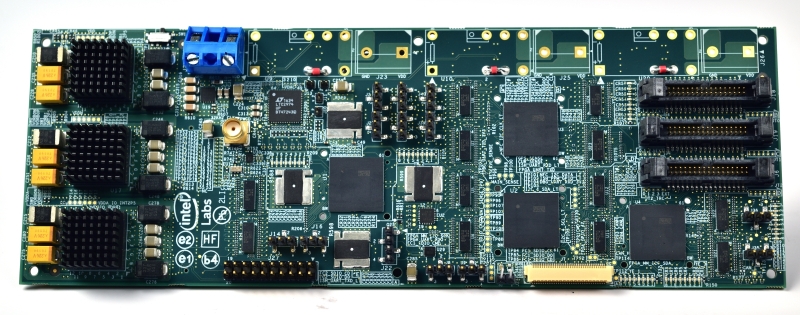

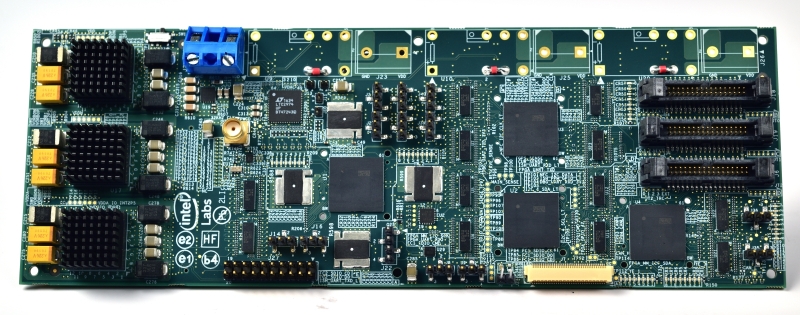

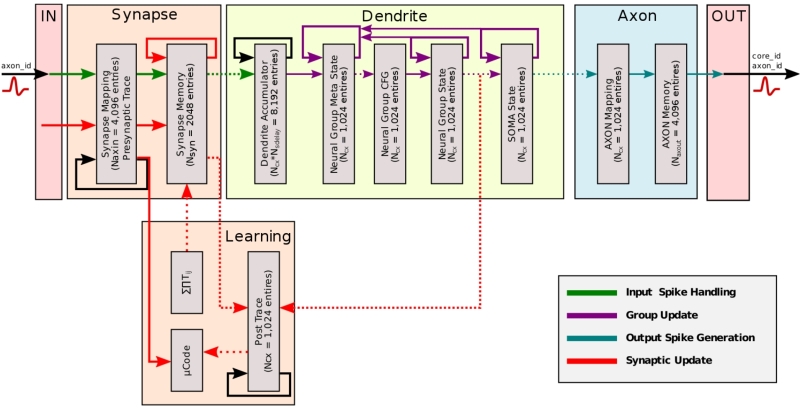

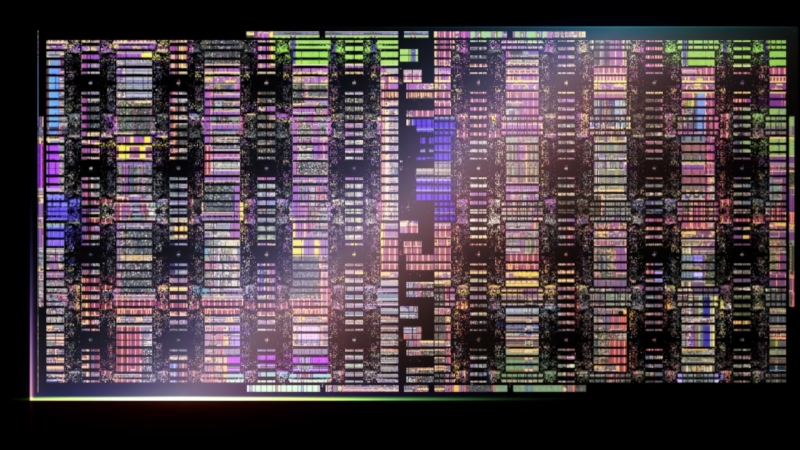

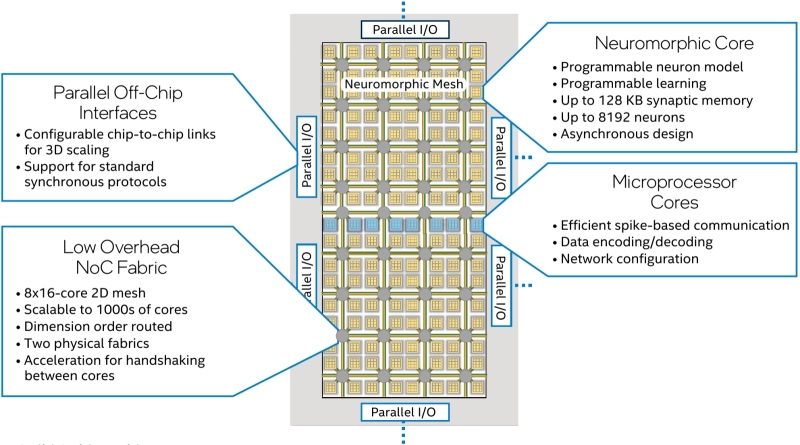

Официальное представление первого нейроморфного процессора Loihi состоялось в 2017 г. — именно как чипа для исследователей, интересующихся этим новым направлением развития ИТ с практической точки зрения и нуждающихся в аппаратной основе для проверки своих гипотез. Изготовленный по «14-нм» технологическим нормам одиночный кремниевый кристалл Loihi занимал площадь в 60 мм² и содержал 2,1 млрд транзисторов. Для управления потоками данных между узлами нейросети (оркестрации) на той же подложке располагались три процессорных х86-ядра Lakemont, тогда как число собственно нейронных ядер достигало 128 — по 1024 искусственных нейрона с 1024 синапсами в каждом. На каждое из ядер приходилось по 208 Кбайт памяти SRAM, причём текущее состояние (local state) каждого из нейронов описывалось 24-разрядным числом. Главная же особенность архитектуры Loihi и наследующей ей Loihi 2 — в том, что они реализуют асинхронные импульсные нейронные сети (spiking neural networks, SNN), о которых мы говорили в прошлом материале, посвящённом нейроморфным вычислителям. Вместо того чтобы манипулировать фиксированными уровнями поступающих на входы сигналов (интерпретируя эти уровни как коэффициенты для последующего взвешенного суммирования), нейроны импульсных сетей реагируют на собственно импульсы — сам факт поступления которых и кодирует некие данные.

Асинхронный же характер SNN, реализованной в Loihi, означает отсутствие общего, единого для всей нейронной структуры «ведущего ритма», исключительно по тактам которого на синапсы нейронов могли бы поступать или не поступать сигнальные импульсы: здесь сигналы распространяются между узлами сети без привязки к общему расписанию. Время от времени, в соответствии с конкретным своим состоянием, отдельный нейрон генерирует тот самый спайк, что дал название этому типу нейросетей, — одиночный импульс, аналог потенциала действия у биологического нейрона, — и рассылает тот своим соседям по прямым контактам, именуемым синапсами (сходство с биологическими синапсами здесь чисто функциональное; никаких синаптических щелей и нейромедиаторов, по крайней мере на нынешнем этапе развития технологий, кремниевая реализация нейроморфного вычислителя не предусматривает). Когда именно каждый конкретный нейрон породит очередной спайк, определяет уже упомянутая функция его состояния (local state). Таким образом выстраивается динамичная высокосвязная сеть, в которой — в отличие от перцептронных слоёв «обычных» глубоких нейросетей (которые называют просто искусственными, без дальнейшей конкретизации: artificial neural network, ANN) — узлы взаимодействуют в индивидуальном порядке, обмениваясь унифицированными однобитовыми импульсами.

Принимающий такие импульсы от своих соседей нейрон в составе SNN накапливает их — и по достижении некоторого порога срабатывает сам, порождая и рассылая связанным уже с ним нейронам очередной потенциал действия. Рассылка эта производится посредством также асинхронной сети-на-чипе (network-on-chip, NoC), которая обеспечивает доставку нейроморфным ядрам (искусственным нейронам) соответствующих сигналов, причём коммуникационный протокол предусматривает масштабирование этой сети до 4096 ядер на одном чипе (в первом поколении Loihi их, впрочем, всего 128), а с применением иерархической адресации — до 16 384 чипов. Функция состояния у каждого нейроморфного ядра (отдельного искусственного нейрона) — своя; она меняется в процессе обучения нейросети и определяет в конечном итоге, когда именно (т. е. по получении какого числа входных спайков) данное ядро сформирует свой собственный импульс. Нейроморфные ядра Loihi содержат «обучающий контур» (learning engine), при помощи которого можно корректировать значимость каждого из синапсов, причём интегрированные ячейки памяти SRAM позволяют фиксировать приобретаемые ими в ходе обучения настройки, обновляя их по мере того, как нейросеть совершенствуется в исполнении доверенной ей задачи — будь то распознавание образов или управление роботизированным механизмом.

Именно в этом отношении, как утверждали разработчики первого поколения Loihi, их детище превосходило имевшихся ко времени его появления конкурентов, среди которых наиболее известен нейропроцессор IBM под названием TrueNorth (проект по разработке которого стартовал ещё в 2008 г. под эгидой небезызвестного агентства DARPA). TrueNorth — как и разработанный в Стэнфордском университете Neurogrid, и система BrainScaleS из Гейдельбергского университета, и проект группы из Университета Манчестера нейросимулятор SpiNNaker на основе более 1 млн ядер ARM9 — с успехом эмулируют существенно многоканальную параллельную работу биологических нейронных структур за счёт формирования выделенных каналов передачи данных между нейроморфными ядрами, каждое из которых оснащено многими сотнями и тысячами синапсов. Но само по себе выделение этих каналов — к которому сводится обучение нейросети, т. е. формирование структуры синаптических связей в искусственном «мозге», — производится офлайн, чаще всего в ходе эмуляции работы нейроморфной системы на фон-неймановском суперкомпьютере. Loihi же за счёт более изощрённой архитектуры с распределённой синаптической памятью пригоден как для тренировки, так и для исполнения усвоенных ранее им же самим моделей поведения, — и в этом смысле на момент появления он считался уникальным.

⇡#Второй заход

Какой же смысл создавать нейроморфные вычислители на кремниевой основе — если всё равно для организации потоков данных между отдельными их узлами в рамках гибридной сети (гибридной, поскольку даже если внутри одного нейрочипа синаптическая сеть «честно» организована на уровне шинной разводки, то передача данных между соседними чипами возможна лишь через коммутаторы) приходится привлекать вполне классические полупроводниковые межсоединения и фон-неймановские процессорные ядра — архитектуры x86 либо ARM?

А смысл в том, что по сравнению с сопоставимыми по технологическим нормам производства фон-неймановскими процессорами нейроморфные, даже кремниевые, оказываются гораздо энергоэффективнее в решении целого ряда прикладных задач: порождение одиночных спайков, пусть даже и с высокой частотой, выходит куда более экономичным, чем постоянная подача напряжения на классические полупроводниковые СБИС. Скажем, один из методов регрессионного анализа — это когда исследуется влияние одной или нескольких независимых переменных на одну зависимую, — LASSO (least absolute shrinkage and selection operator), требует для своей реализации на Loihi первого поколения на три десятичных порядка меньше энергии, чем при использовании виртуальной нейросети в памяти фон-неймановской машины, запущенной на выполненных по тем же «14-нм» нормам процессорах. А к такого рода многопараметрическим задачам исследования зависимостей сводится множество повседневных проблем — от оценки потребительского спроса на некий товар с заданными характеристиками (при условии удачной математической формализации отличия этих характеристики от среднерыночных) до уже не раз упомянутого машинного распознавания образов.

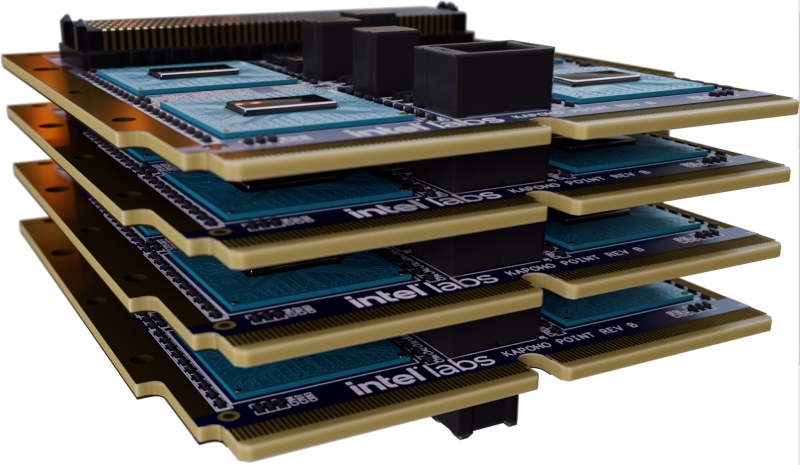

В сентябре 2021 г. Intel представила общественности второе поколение своего нейроморфного чипа — Loihi 2. При вдвое миниатюризированной производственной норме — «Intel 4», что примерно соответствует «7 нм» в терминологии TSMC, — он вышел почти в два раза меньшим по площади (31 мм²), однако число искусственных нейронов в нём выросло восьмикратно — с примерно 130 тыс. до около 1 млн. Вместе с выпуском новинки на Github была выложена и специализированная среда разработки для него, Lava, основанная на Java и распространяемая как Open Source. Таким образом, любой интересующийся нейроморфными вычислениями программист имеет теперь возможность создать свой код для Loihi 2, оттестировать и проверить его готовность к работе на эмуляции в памяти фон-неймановской системы, а затем уже задумываться о возможности запуска его на соответствующей аппаратной платформе. Микрокод, что действует на уровне оркеструющих функционирование нейроморфных ядер х86-чипов, позволяет назначать переменные и исполнять целый ряд инструкций в виде коротких программ на языке ассемблера: по заявлению Intel, это «обеспечивает доступ к памяти на уровне отдельных нейронов, к величине накопленного на определённый момент синаптического ввода, к счётчикам шагов в случае ограниченных по времени вычислений» и в целом значительно повышает гибкость организуемых на такой аппаратной основе нейросетей. Вдобавок чипы Loihi 2 допускают не только плоскостное, но и трёхмерное совместное размещение за счёт специально доработанных межмикросхемных соединений — и с учётом того, что теплорассеяние нейроморфного вычислителя значительно меньше, чем фон-неймановского процессора тех же габаритов, выполненного по схожим производственным нормам, упаковывать слои Loihi 2, по крайней мере в теории, можно достаточно плотно.

Интересно, что ещё в начале 2019 г. на глобальной конференции в Сан-Франциско, посвящённой полупроводникам, импульсные нейроморфные вычислители довольно резко раскритиковал Ян Лекан (Yann LeCun), тогда ещё сотрудник Facebook*, давний и яростный апологет глубокого обучения, — раскритиковал за то, что при всей ее бесспорной экономичности «для этой технологии так до сих пор и не предложено алгоритмов, которые принесли бы действительно полезные практические плоды: и зачем создавать чипы под алгоритмы, которые не работают?». В ответ на это выступавший буквально следом за ним Майк Дэвис (Mike Davies), глава нейроморфного исследовательского подразделения Intel, язвительно заметил, что «обратное распространение ошибки не имеет отношения к тому, как работает мозг (backpropogation doesn’t correlate to the brain)», так что «глубокое обучение», основа основ архипопулярного сегодня генеративного ИИ, — и не обучение никакое вовсе, а довольно затратная в аппаратном и энергетическом плане процедура оптимизации. В качестве примера Дэвис привёл некую прикладную задачу классификации (вот как раз идеальная область применения регрессионного анализа), при решении которой машина ещё на первом поколении Loihi выдала результат на 8% более точный и в сорок раз быстрее, чем одна из наиболее передовых на тот момент систем глубокого обучения, запущенная на мощном (опять-таки для тех времён) серверном графическом ускорителе.

Справедливости ради отметим, что у кремниевых нейроморфных вычислителей, в особенности с малым числом нейронных ядер, при всей их функциональной близости к биологическому прототипу имеются вполне объективные проблемы с точностью. В конце 2018 г. исследователи из Applied Brain Research опубликовали отчёт, согласно которому алгоритм распознавания речи, запущенный на различных аппаратно-программных комплексах с нейросетями, действительно исполнялся на Loihi первого поколения быстрее многих прочих и со значительно меньшими затратами энергии, — зато в плане точности (подсчитывалась совокупность как корректных отождествлений тестовой фразы, так и верных отказов распознавать её в намеренно искажённом наборе звуков) фон-неймановские платформы с генеративными нейросетями, построенными по принципам глубокого обучения, дали ему фору.

Майка Дэвиса, как и других сторонников нейроморфных вычислителей, это, впрочем, не смущает: они утверждают, что чем обширнее сеть нейронных ядер, тем точнее будут выдаваемые ею ответы, — ведь и слон с его 4-5-килограммовым мозгом решает куда более сложные задачи, чем какие-нибудь нематоды со считаными сотнями нервных клеток. Более того, энтузиасты нейроморфики уверены, что как только подобными системами начнут оснащать роботов, предназначенных для прямого автономного взаимодействия с объектами реального мира, — вот тут-то и начнётся её золотой век. «Мозг эволюционировал для того, чтобы управлять конечностями», — напомнил Дэвис; собственно, высокая отзывчивость импульсной нейросети на неупорядоченные внешние сигналы (раздражители) действительно весьма точно соответствует особенностям поведения биологической нервной ткани.

⇡#Проблемы и решения

Вот уже около двух лет многослойные (глубокие) нейросети с обратным подкреплением, deep neural networks, благодаря успехам ChatGPT, Midjourney, Canva и множеству других проектов, стали для подавляющего большинства человечества синонимом нейронных сетей вообще, задвинув SNN, и без того мало кому на тот момент известные, глубоко в тень. И это не могло не сказаться на развитии самих импульсных нейронных сетей. В 2023 г. всё тот же Майк Дэвис в интервью изданию EE Times уже не был так категоричен в оценке бесспорного превосходства нейроморфики над глубоким обучением: «Loihi 2 стал лучше первой версии во многих весьма интересных отношениях. Он начал размывать границу между чистым нейроморфным подходом — и традиционной архитектурой ускорителя искусственного интеллекта, и это подтолкнуло нас к изучению новых интересных алгоритмов. Лучший подход — не обязательно тот, что точнее всего соответствует биологической нейросети. Просто поразительно, чего смогла добиться природа, оперируя лишь унифицированными потенциалами действия, — но мы, усиливая чисто биологический подход путём добавления к нему обратного распространения ошибки, достигнем, уверен, новых поистине воодушевляющих возможностей».

И это не просто слова: одна из ключевых особенностей Loihi 2 — готовность оперировать спайками различных амплитуд, что в корне противоречит уже упоминавшейся нами нейробиологической догме «всё или ничего»: та подразумевает, что вне зависимости от силы стимула реакция в виде потенциалов действия всегда однотипна в плане величины нервного импульса, — различаться могут разве что количества таких импульсов в серии да продолжительность разделяющих их интервалов «молчания». С математической точки зрения переход к многоамплитудным сигналам означает, что спайки, которыми обмениваются искусственные нейроны в Loihi 2, кодируются уже не бинарными величинами, как в биологической нервной ткани и в Loihi первого поколения, а целыми числами определённой разрядности. Именно такой подход позволяет на уровне микрокода, управляющего этими нейронами, производить арифметические операции над поступающими на них сигналами и программно контролировать исполнение инструкций — создавая в перспективе гибридные (между глубокими ANN и SNN) нейронные сети с разнообразными моделями нейронов.

А вот это уже совсем интересно: вместо рабской имитации природной нервной сети — которая возникала в процессе эволюции, строго говоря, без чётко поставленной цели предоставить в конечном итоге виду Homo sapiens возможность создавать уже искусственные нейростети — исследователи имеют теперь возможность проектировать те или иные виды нейронов, оптимизированных для решения разного рода задач, а затем комбинировать их в пределах общей сети ради оптимизации её работы как целого. Опять-таки, здесь прослеживается явная перекличка с неоднородностью структуры биологического мозга, разные отделы которого исполняют свои функции. А значит, на таком искусственно усиленном (Дэвис использует термин «augmented») аппаратном субстрате куда эффективнее можно будет реализовывать максимально приближенные к реальности по функциональным особенностям, пусть и не воспроизводящие её структурно, нейросетевые модели.

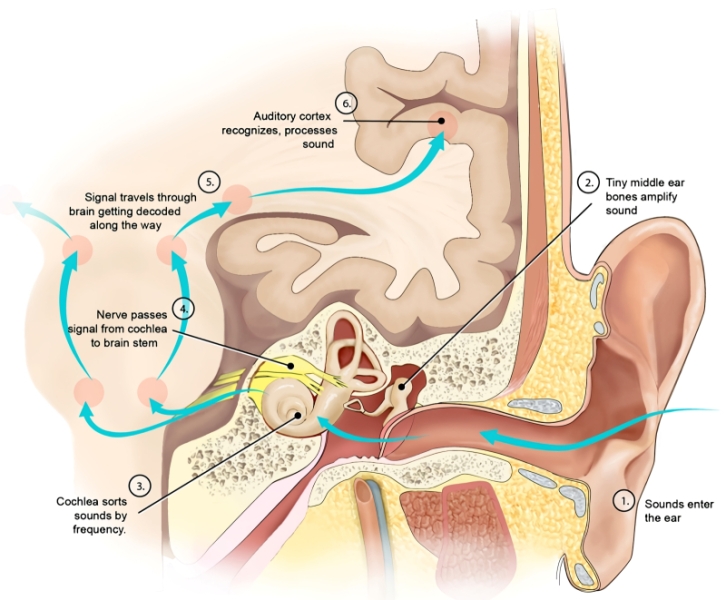

Живой пример одной из таких моделей — искусственные нейроны, действующие по принципу «резонировать-и-сработать» (resonate-and-fire), т. е. активирующиеся в ответ на раздражитель определённой частоты, близкой к их собственной частоте как колебательной системы. Такие нейроны моделируют с применением резонаторов Хопфа (основанных на математической бифуркации Андронова — Хопфа), что позволяет воспринимать крайне широкий частотный диапазон доступных живым организмам звуков на сравнительно скромной аппаратной базе. Как раз с применением Loihi 2 эти резонаторы реализуются на гибридных нейросетях наиболее бюджетным — имеется в виду энергетический бюджет, конечно, — образом. Предложенное решение имеет вполне практическую значимость: для автоматизированных систем распознавания речи крайне важна нормализация входящего аудиопотока — иначе требуется дополнительное время на адаптацию системы к восприятию слишком тихих или чересчур громких звуков, что часто ведёт к потере данных. Разночастотные же резонаторы Хопфа, сведённые в искусственную улитку (отдел внутреннего уха, как раз и отвечающий за первичное акустическое восприятие), снимают проблему нормализации с повестки дня.

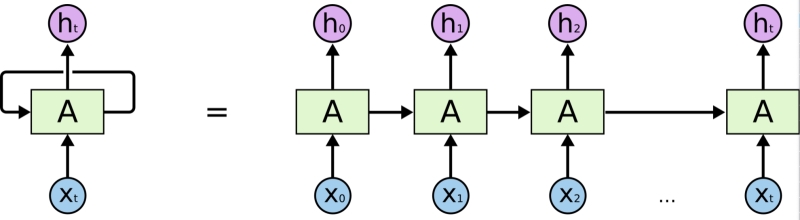

На фоне последних успехов многослойных (глубоких) нейросетей, в особенности опирающихся на архитектуру трансформеров, вне зоны пристального внимания исследователей долго оставалась рекуррентная их разновидность (recurrent neural network, RNN) — к которой, строго говоря, относятся SNN. В отличие от простых сетей с прямой связью (feedforward neural network, FNN), где данные обрабатываются строго за один проход, в рекуррентных реализуется многопроходная обработка с фиксацией в локальной памяти результатов предыдущих итераций — что делает их едва ли не идеальными, в частности, для задач вроде машинного перевода или генерации речи. Натренированная на определённых последовательностях данных, RNN образует модель машинного обучения, способную с высокой точностью (или, в случае речи, с отменным правдоподобием) предсказывать, каким должен быть очередной элемент в уже начатой последовательности.

В настоящее время по сути ту же функциональность реализуют FNN с трансформерами — в архитектуре кодирования-декодирования с опорой на «слои внимания» (attention layers). Разработчики из Intel рассчитывают продолжить комбинирование RNN, реализациями которых выступают чипы Loihi первого и второго поколений, с лучшими достижениями FNN — включая сравнительно высокую скорость тренировки (рекуррентные нейросети накапливают информацию, корректируя свои параметры в ходе обучения, значительно медленнее) и сравнительно малый объём локальной памяти (продолжать короткие последовательности они научаются очень хорошо, средние по длине — похуже, а с длинными справляются крайне неуверенно). В интервью EE Times 2023 г. Майк Дэвис говорил о стремлении своей команды найти способ преобразования сетей с прямой связью в рекуррентные — сохраняя все очевидные на сегодня преимущества первых и не поступаясь притом бесспорными достижениями вторых.

Удастся ли это Intel, вопрос непростой — особенно если учесть нынешнее её финансовое состояние. К тому же, напомним, по разным оценкам, подъём подводного вулкана Лоихи, давшего название перспективному SNN-чипу, займёт от 10 до 100 тыс. лет, — было бы хорошо, если бы эволюция нейроморфных кремниевых чипов шла несколько более быстрыми темпами. И если Loihi 3 в обозримой перспективе всё же появится, есть шанс, что непомерные ныне энергетические аппетиты моделей машинного обучения удастся существенно умерить. По крайней мере, в отношении ряда весьма серьёзных прикладных — робототехнических, в частности, — задач, что в плане как можно более повсеместного внедрения подлинно автономных систем уже окажется вполне достойным результатом.

⇡#Материалы по теме

- Корейские учёные создали гибрид оперативной и флеш-памяти со сверхнизким потреблением.

- Инъекция протонов превратит ферроэлектрик в основу для кремниевого «мозга».

- Нетрадиционные вычисления: британские учёные намерены создать компьютер из грибов.

- Kaspersky представила Neuromorphic Platform — платформу для разработки решений на российском нейроморфном чипе «Алтай».

- Intel Labs представила нейроморфный ускоритель Kapoho Point — 8 млн электронных нейронов на 10-см плате.

- Кремний-выручалочка

- Второй заход

- Проблемы и решения

- Материалы по теме